麻省理工学院媒体实验室(MIT Media Lab)的研究人员在2月份发表的一项研究发现:与肤色较浅的男性相比,由IBM、微软和旷视科技(Face++)设计的面部识别算法在检测肤色较深的女性时,其出错率要高出35%。通过这种方式,面部识别的技术偏见可能会强化社会偏见,影响女性和少数族裔,亦有可能将他们排除在世界数字基础设施之外,或对他们做出改变人生的判断。

一、是时候建立应对技术偏见的全行业标准

以上所述是个坏消息,更坏的消息是,公司还没有解决这个问题的计划。尽管个别公司正在其自主研发的软件中解决面部识别中的技术偏见,但专家们表示,没有任何统一的标准可以在整个行业范围内同步实施。因此,当公司在其算法中减少偏见的时候(正如微软上个月宣布的那样),很难判断这有多大意义。

乔治城大学隐私与技术中心的研究员克莱尔·加维(Clare Garvie)表示,很多人认为现在是时候引入全行业的偏见和准确性的基准测试了:测试算法在不同的人口统计数据上的表现,比如年龄、性别和肤色。“我认为这将是非常有益的,”Garvie说。“特别是对于那些将与政府机构签约的公司。”对于公司来说,面部识别应用已经变得比以往任何时候都要容易。

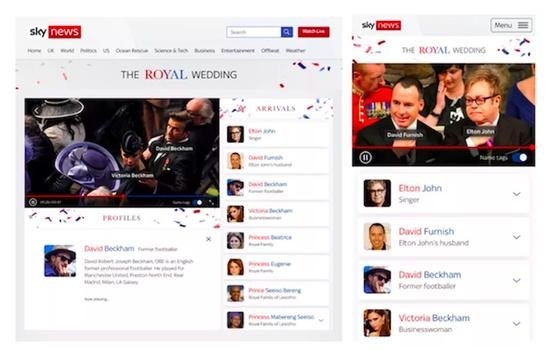

(图1:今年5月,英国天空广播公司(Sky)利用亚马逊的面部识别API接口来识别名人。)

二、科技行业有哪些解决方案?

在一项非正式调查中,The Verge联系了十几家出售面部识别、验证和分析算法的公司。所有回复的公司都说他们意识到了偏见的问题,而且大多数公司都说他们正在尽最大努力在他们自己的系统中减少这种偏见。但没有人会分享他们工作的详细数据,或者透露他们自己的内部指标。如果你经常使用面部识别算法,难道你不愿意知道它是否一直在性别或肤色项目上表现欠佳吗?

谷歌只销售人脸识别的算法,而不是身份信息。谷歌表示:“我们确实测试了偏见,而且我们一直在测试我们的底层模型,以减少技术偏见带来的不公平。在这个时候,我们没有更多的细节来分享。”

微软分享了其近期的改进,包括软件在性别识别方面的进展,目前其对肤色较深的女性的识别错误率为1.9%(低于20.8%)。该公司没有提供官方声明,但其首席法律顾问布拉德·史密斯(Brad Smith)在7月份发表的一篇博客文章提到了这一点。史密斯表示,现在是时候让美国政府监管自身对面部识别的使用了,尽管不是由私营企业来部署。也许,还应包括设定最低的精确度标准。

IBM还强调了最近的改进,以及上个月发布的一套用于训练面部识别系统的多样化数据集,旨在对抗偏见。IBM Watson的首席设计师鲁希尔·普里(Ruchir Puri)于6月份曾表示,该公司有意帮助建立准确的基准。普里说:“应该有许多这样的基准来评判。”“但这种判断应该由团体来做,而不是由任何特定的参与者来做。”

(图2:亚马逊人脸识别系统将28名国会议员识别为罪犯)

亚马逊没有回应这个问题,而是于今年早些时候在发表的声明中提到,该公司曾因向执法部门出售面部识别技术而受到ACLU(美国公民自由联盟)的批评。(ACLU最近也提出了类似的批评:它测试了该公司的面部识别软件,以识别国会成员的照片,并发现他们错误地将28个人与犯罪照片相匹配。)

亚马逊表示,如果用户将算法应用于非法歧视或侵犯公众的隐私权,他们将对该用户撤销权限,但没有提及任何形式的监管。该公司透露,其团队正在内部进行测试,以分析和消除系统中的偏见,但不会透露更多信息。考虑到亚马逊持续向执法机构出售其算法,这一点值得注意。

在接近边缘的企业供应商中,有些公司根本没有提供直接的回应,包括FaceFirst、Gemalto和NEC。另一些公司,比如一家向世界各地的执法部门和边境机构销售面部识别算法的德国公司科尼特克公司(Cognitec)承认,如果没有正确的数据,消除偏见很难。

“可用的数据库往往是有偏见的,”科尼特公司的市场经理埃尔克·奥伯格(Elke Oberg)表示。“数据库可能只包含白人,因为这是供应商提供的模型。”奥伯格说,科尼特公司在不同的数据上做了最好的训练,但他说,市场力量将淘汰糟糕的算法。“所有的供应商都在研究这个问题,因为公众已经意识到了这一点,”她说。“我认为,如果你想作为一个供应商生存下去,你肯定需要在高度多样化的数据上训练你的算法。”

三、如何解决偏见的问题?

这些答案表明,尽管人们意识到偏见的问题,但没有应对的措施。那么该怎么办呢?大多数专家建议的解决方案在概念上是简单的,但却难以实现:为准确性和偏差创建全行业的测试。

有趣的是,这样的测试已经存在了。它被称为FRVT(人脸识别供应商测试),由美国国家标准技术研究院(NIST)管理。它测试了几十个面部识别系统在不同情况下的准确性,比如将护照照片与站在边境门上的人相匹配,或者在数据库中匹配闭路电视片段和脸部照片。它还测试了“人口差异”——算法是如何基于性别、年龄和种族来进行面部识别的。

然而,FRVT是完全自愿的,提交其算法的组织往往是试图向政府出售服务的企业供应商,或者是学者测试新的、实验性的模型。像NEC和Gemalto这样的小公司提交了他们的算法,但是没有一家大型的商业科技公司这么做。

Garvie认为,扩大FRVT的覆盖范围,而不是为面部识别的准确性创造新的测试,可能是一个好主意。“NIST在进行这些测试方面做得非常出色,”Garvie说。“但他们的资源也有限。我怀疑我们需要立法或联邦资金支持来提高NIST测试其他公司的能力。”另一个挑战是,像亚马逊和微软这样的公司部署的深度学习算法很难被送去分析。这些算法是不断更新的软件的巨大组成部分,与老式的面部识别系统非常不同,后者通常可以安装在一个u盘上。

在接受The Verge采访时,NIST的生物识别标准和测试主管帕特里克·格罗瑟(Patrick Grother)明确表示,该组织目前的角色不是监管。“我们不做监管,我们不制定政策。我们只生产数字,”格罗瑟说。NIST近20年来一直在测试面部识别算法的准确性,目前正在准备一份专门针对偏见问题的年底报告。

格罗瑟表示,尽管自NIST开始测试以来,“错误数量大幅减少”,但不同算法的性能之间仍然存在很大的差异。“不是每个人都能做面部识别,但很多人认为他们能做到,”他说。

格罗瑟说,最近关于偏见的讨论经常会混淆不同类型的问题。他指出,尽管训练数据集缺乏多样性会造成偏见,但对相关的人像采集拍摄也会产生偏见,尤其是当肤色没有被适当地暴露出来的时候。类似地,不同类型的错误在应用于不同类型的任务时意味着更多。所有这些细微之处都需要考虑到基准或监管。

四、偏见并不是唯一的问题

关于偏见的讨论还引发了其他关于社会使用面部识别的问题。

人工智能科学家Joy Buolamwini是麻省理工学院的研究人员(从事性别识别算法不同准确率的研究工作),他表示,仅仅解决偏见并不能完全解决这些更广泛的问题。“开发面部分析技术,然后将其武器化,有什么好处呢?我们需要一种更全面的方法,将面部分析技术作为一个社会技术问题来对待。技术上的考虑不能与社会影响相分离。”

(图三:人脸识别应用于边境检查)

Buolamwini和其他人工智能团队成员对这些问题采取了积极的态度。面部识别供应商Kairos的首席执行官布莱恩·布雷克(Brian Brackeen)特最近宣布,其公司不会向执法部门出售面部识别系统,因为有被滥用的可能性。

布雷克表示,当涉及到面部识别的商业部署时,市场力量将有助于消除偏见算法。但是他同时表示,当这些工具被政府使用时,风险要高得多。这是因为联邦机构可以获得更多的数据,这增加了这些系统被用于抑制监视的可能性。(据估计,美国政府持有该国一半成年人口的面部数据。)类似地,政府使用这些算法做出的决定将对个人的生活产生更大的影响。

“执法的用例不只是街上的摄像头,而是身体摄像头、脸部照片,”布雷克说,如果偏见是这些场景中的一个因素,那么“你就有了一个更大的可能性让一个有色人种被错误地指控为犯罪。”

因此,关于偏见的讨论似乎只是一场更大辩论的开始。正如Buolamwini所述,基准测试可以发挥他们的作用,但还需要做更多的工作:“开发这些工具的公司、研究人员和学者必须承担责任,在他们想要减轻损害的情况下,对他们开发的系统设置条件限制。”